一、蜘蛛爬取问题

在网络爬虫的领域中,蜘蛛(Spider)是一种程序,被用于自动获取网页信息。蜘蛛在执行爬取任务时可能会面临一系列问题。这些问题不仅影响了数据的准确性,还对爬虫的效率和稳定性构成了挑战。

1.1 IP封锁与反爬机制

许多网站为了防止恶意爬虫的访问,会采取IP封锁或其他反爬机制。当蜘蛛频繁访问目标站点时,就容易触发这些机制,导致IP被封锁。解决这一问题需要采取一系列手段,如使用代理IP、降低爬取频率等。

1.2 动态加载内容

随着前端技术的发展,许多网站采用了动态加载内容的方式,使得传统的爬虫难以获取完整的页面信息。为了解决这一问题,爬虫需要使用支持JavaScript渲染的工具,如Selenium,来模拟浏览器行为。

1.3 长时间运行和资源消耗

一些网站可能存在大量数据需要爬取,而蜘蛛长时间运行会带来资源消耗的问题。为了提高效率,爬虫需要采用合理的算法和策略,避免对目标服务器造成过大负担。

二、爬虫过程中遇到的问题

2.1 数据存储与清洗

在爬虫获取到数据后,面临着数据存储和清洗的问题。数据存储需要选择合适的数据库或文件格式,而数据清洗则需要处理各种可能存在的异常情况,确保数据的质量和一致性。

2.2 反爬策略的更新

随着反爬技术的不断升级,网站的反爬策略也在更新。爬虫需要及时适应新的反爬措施,保证爬取任务的顺利进行。这要求爬虫开发者具备不断学习和更新的能力。

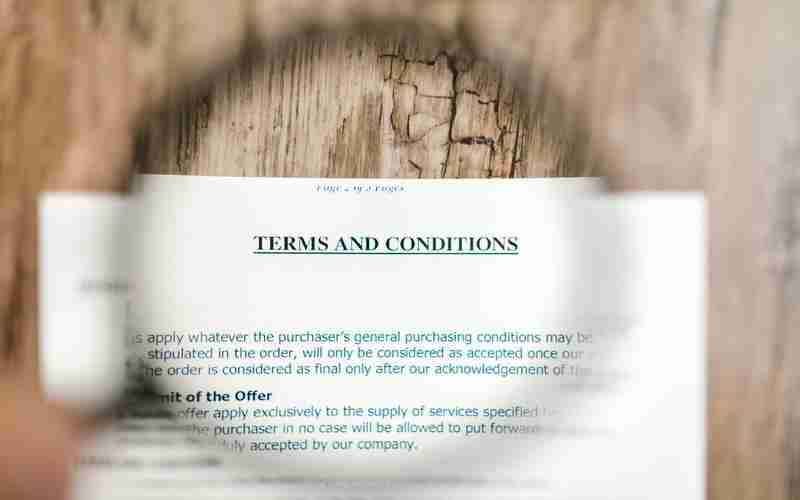

2.3 与法律问题

爬虫活动可能涉及到隐私、版权等法律和问题。在进行爬虫开发时,开发者需要遵守相关法规和道德规范,避免触犯法律,保护用户隐私和维护公平竞争。

三、总结与展望

在蜘蛛爬取问题和爬虫过程中遇到的问题中,挑战与机遇并存。解决这些问题需要爬虫开发者具备丰富的经验和不断学习的能力。未来,随着互联网技术的不断发展,爬虫将在更多领域发挥重要作用,对于爬虫技术的研究和应用仍有待深入探讨。