本文目录一览:

- 1、登录网站出现由于该网站的robots.txt文件存在限制指令(限制搜索引擎...

- 2、2012-2013 搜索引擎之争与robots协议诉讼

- 3、robot可以限制爬虫程序采集某些网页的数据是对的还是错的

- 4、由于该网站的robots.txt文件存在限制指令,系统无法提供该页面的内容描...

- 5、浅析网站Robots协议语法及使用

- 6、Python爬虫必须遵守robots协议,否则等于犯罪

登录网站出现由于该网站的robots.txt文件存在限制指令(限制搜索引擎...

1、其实这是因为搜索引擎用的抓取程序Spider为了保护网站数据隐私而共同遵守一个叫做Robots协议的东东,网站管理者可以通过Robots告诉搜索引擎某些内容不允许其进行收集。。。

2、如果将网站视为酒店里的一个房间,robots.txt就是主人在房间门口悬挂的“请勿打扰”或“欢迎打扫”的提示牌。

3、用其他搜索引擎试试。这个 robots.txt 东西是一种“协议”告诉搜索引擎,请不要搜索这个文件里所声明的东西。这不是必须遵守的,但是一般正规服务商都会自动遵守这个协议。

4、文件收到robots.txt协议的限制,意思就是说没有权限进入该页面了,这个要网站的负责人去修改规则才能够访问该页面的内容了。

2012-2013 搜索引擎之争与robots协议诉讼

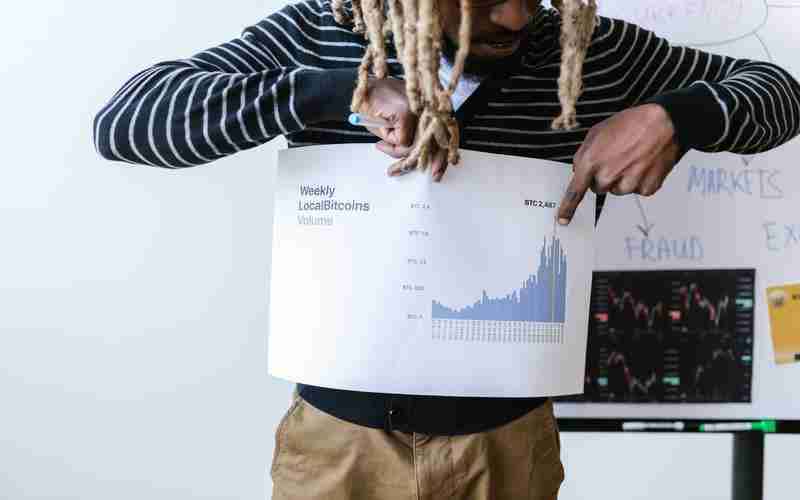

1、某度和某虎争夺搜索引擎市场,初期就爆发了一系列诉讼,其中与Robots协议相关的有三个案子,目前两个审结、一个待结。背景 2012年8月16日,360搜索引擎服务上线当天双方就产生摩擦。

2、2014年8月,百度诉360违反Robots协议案于2013年由百度向法院提起诉讼。

3、robots协议命名为robots.txt,放在网站的根目录下。 简单的robots协议如下:其中 User-agent 代表要遵守该协议的搜索引擎,如果是通配符‘*’,代表所有搜索引擎都要遵守该协议。

robot可以限制爬虫程序采集某些网页的数据是对的还是错的

网络爬虫机器人: "bot" 也用来描述网络爬虫程序,这些程序自动扫描互联网上的网页,收集信息或执行其他任务。例句:"Search engines use bots to index and analyze web pages."(搜索引擎使用机器人来索引和分析网页。

Robots.txt - 禁止爬虫robots.txt用于禁止网络爬虫访问网站指定目录。robots.txt的格式采用面向行的语法:空行、注释行(以#打头)、规则行。规则行的格式为:Field: value。常见的规则行:User-Agent、Disallow、Allow行。

因此,没有任何理由可以支持这种做法。【ATW】AllTheWeb的缩写,由FAST所支持的搜索引擎。【Bot】机器人(蜘蛛)的缩写,指扫描网络的软件程序。机器人有各种不同的目的,包括索引网页搜索引擎抓取,采集电子邮件等。

由于该网站的robots.txt文件存在限制指令,系统无法提供该页面的内容描...

这个 robots.txt 东西是一种“协议”告诉搜索引擎,请不要搜索这个文件里所声明的东西。这不是必须遵守的,但是一般正规服务商都会自动遵守这个协议。

其实这是因为搜索引擎用的抓取程序Spider为了保护网站数据隐私而共同遵守一个叫做Robots协议的东东,网站管理者可以通过Robots告诉搜索引擎某些内容不允许其进行收集。。。

文件收到robots.txt协议的限制,意思就是说没有权限进入该页面了,这个要网站的负责人去修改规则才能够访问该页面的内容了。

字,并且不会出现这个网站的元标签描述部分。对应的元标签描述部分将由最新上线的robots提示代替,比如,用户在搜索淘宝网时,出现“由于该网站的 robots.txt文件存在限制指令,系统无法提供该页面的内容描述 - 了解详情”字样。

浅析网站Robots协议语法及使用

1、网站改版正确使用robots文件的方法是:在改版期间,将robots文件设置为“disallow: /”以阻止搜索引擎访问网站,然后在改版完成后,根据新网站的结构和内容,更新robots文件以允许搜索引擎重新访问网站。

2、robots.txt应放置于网站的根目录下。如果想单独定义搜索引擎的漫游器访问子目录时的行为,那么可以将自定的设置合并到根目录下的robots.txt,或者使用robots元数据(Metadata,又称元数据)。

3、robots.txt文件里的内容如下示例:User-agent:Disallow: /php Allow: /php 其中:User-agent这个语法是定义搜索引擎爬取程序的。

Python爬虫必须遵守robots协议,否则等于犯罪

1、Robots协议(也称为爬虫协议、机器人协议等)的全称是“网络爬虫排除标准”(Robots Exclusion Protocol),网站通过Robots协议告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取。

2、Robots协议是建议但非约束性,网络爬虫可以不遵守,但存在法律风险。 原则:类人行为可以不参考Robots协议。

3、网络爬虫技术的应用确实存在一些合法性和数据安全的争议。在使用爬虫技术时,我们应该遵守相关法律法规,尊重网站的使用规则,并确保采集的数据不侵犯他人的合法权益。

4、爬虫本身并不违法,作为一种技术,本身不存在违法的问题,关键是用爬虫爬什么,以及怎么爬。所有爬虫都要遵守Robots协议,虽然Robots协议并不是强制性要求,但由此可能引发法律纠纷等问题。